Wie funktioniert Alexa?

Wie kann ein Computer, der nur 0en und 1en verstehen, mit Dir reden?

Ich verrate Dir, wie Alexa funktioniert und was Amazon für einen Aufwand betreibt …

Starten wir!

Virtuelle Assistent überall und selbstverständlich

Siri war eine der ersten bekannten virtuellen Assistenten. Apple kauft Siri Inc. in 2010, um die Software auf allen ihren Geräten verwendbar zu machen. Amazon hat die virtuelle Assistentin Alexa in 2014 erschaffen, die in viele Häuser weltweit eingezogen ist.

Alexa unterstützt ihre Nutzer mit Sprachsuchen im Web, liest ein Kochrezept vor oder erinnert diese an ihre Termine.

Aber … Wie funktioniert Alexa?

Die Sprachverarbeitung im Computer

In den 70er Jahren waren digitale Assistenten Science-Fiction, was für uns Cyberpunk 2077 heute ist.

Steffen Lippke

In den 70er Jahren waren noch nicht die Hardware, Software und die passenden Daten verfügbar, um eine so mächtige Anwendung umzusetzen und zu nutzen.

Wenn Informatiker Sprachen lernen …

Die Wissenschaft hinter „Alexa“ ist die natürliche Sprachverarbeitung. Natural Language Processing (NLP) ist ein Teilbereich der Informatik, welches interdisziplinär Sprachwissenschaften, Mathematik und Physik miteinbezieht.

Wie kann ein Computer aus 0 und 1 Sprachen verstehen und auf den Befehl angemessen reagieren?

Nice to know: Das Gerät (Deine Alexa), was Du zu Hause stehen hast, ist fast strohdumm. Die Intelligenz liegt nicht vor Ort, sondern auf den Servern, die Amazon im Hintergrund betreibt.

Steffen Lippke

Im Gegensatz zum menschlichen Hirn ist das Erfassen von Sprache für den Computer sehr schwierig:

- Sprachen sind an vielen Stellen nicht eindeutig (zweideutig, mehrdeutig, mehr-interpretierbar).

- Viele Menschen sprechen undeutlich ( z. B. Dialekt, Nuscheln).

- Der Computer kennt kein Wort und kein Wörterbuch.

- Der Rechner kennt nicht (deutsche) Grammatik Strukturen.

- Der Computer besitzt kein Weltwissen und ist dümmer als ein 3-jähriger.

- Die Maschine kennt den Anwender und seine Umgebung (Kontext) nicht.

Die Forscher der Natural Language Processing haben in den letzten Jahrzehnten eine 7 stufige Verarbeitung von Sprache entwickelt, um auf Deinen akustischen Signalen eine sinnvolle Antwort zu generieren.

Damit meine Erklärung greifbar bleibt, habe ich den folgenden Beispielsatz (Alexa-Befehl) ausgewählt:

Alexa, erinnere mich um 15:00 Jan von der Ronneburg abzuholen.

Alexa Befehl, Gedankenverloren bei der Arbeit….

Von Ton zu den Buchstaben (Phonetik)

Aus Deinem Mund kommt kein W-Lan-Signal, sondern ein Schwall von akustischen Signalen.

Eine phonetische Analyse ermöglicht aus den Signalen Wortlaute zu identifizieren. Um das Wort „erinnern“ zu erkennen, vergleicht der Amazon Server tausende Tonspuren mit Deiner Tonspur.

Falls Du bayrisch sprichst, hat der Server zu kämpfen, weil die „bayrisch-betonten“ Wörter von der hochdeutschen Version abweichen.

Alexa verzweifelt und fragt sich: Ist jetzt eine „Lache“ (Witz) oder „Lache“ (Pfütze) gemeint …

Alexa (schwitzt)

Von den Buchstaben zu den Wörtern (Morphologie)

Die Server bilden aus den erkannten Klängen Buchstaben.

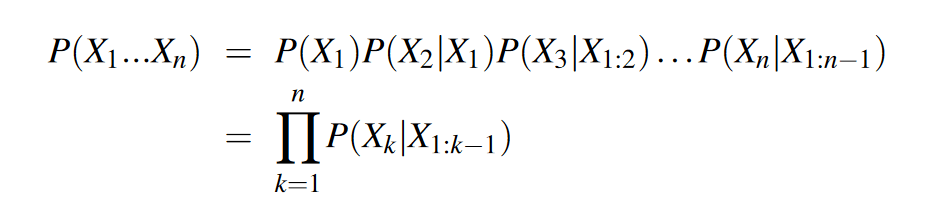

Verschluckte Endungen und Nuscheln korrigiert ein Algorithmus erfolgreich mit etwas Statistik:

Der Server bestimmt die Wahrscheinlichkeiten, welches Wort auf das zuletzt korrekt Gesprochene statistisch gesehen am ehesten zu vermuten ist.

Guten Takk -> Computer -> Guten <???> –> Guten (Tag in 35 % der Fälle)

Wenn der Opa mit Alexa reden würde

Der Alexa Server vergleicht das Nuscheln mit den korrekten Transkriptionen von anderen „verifizierten Genuschel“ ab.

Alexa kommt in Schwitzen und denkt: „Gute(n) Takk“ muss wohl „Guten Tag“ bedeuten.

Sprache ist weder für Menschen eindeutig – noch für den Computer. Meinst Du …

- modern (Möbel) – modern (faules Holz)

- übersetzen (Text) – übersetzen (Boot)

Von den Wörtern zu einem Satz (Syntax)

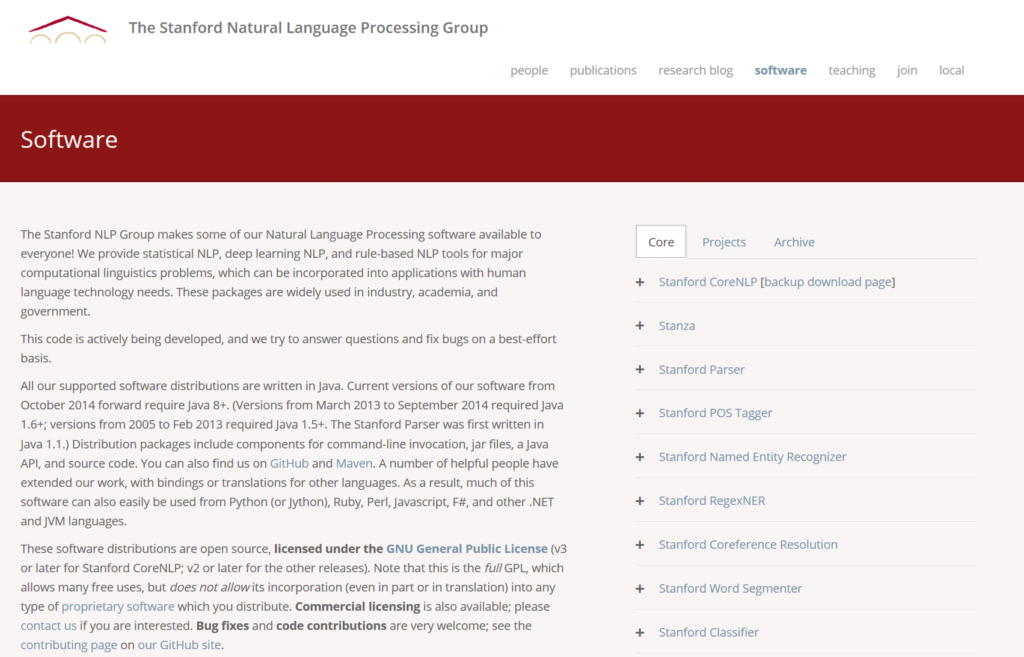

Um den Inhalt zu verstehen, muss der Computer nicht nur die Worte verstehen, sondern auch den ganzen Satz. NLP-Geeks reden beim nächsten Verarbeitungsschritt vom Parsing. Deutsche Sätze stellt der Computer sich als Baum vor (Phrase Structure Trees).

Der Computer beantwortet sich mit den Phrase Structure Trees z. B. die Fragen:

- Wer tut was wann wie?

- Wer interagiert mit wen oder was?

- Wann hat wer was wie wo getan?

Von Satz zur Bedeutung des Gesagten (Semantik)

Wenn Der Computer den Satz als Ganzes erfasst hat, extrahiert er die Stichworte aus den Texten.

Dieser Vorgang nennt sich Name Entity Recognition. Der Computer zapft verschiedene Datenquellen an, um an seine Informationen zu kommen.

Alexa, erinnere mich um 15:00 Jan von der Ronneburg abzuholen.

Inzwischen sucht der Alexa Server und erkennt aus dem Satz:

| Wort | Erkennung | Datenquelle |

| Alexa | Selbstreferenz | Interne Datenbank |

| Erinnere | Kalenderprogramm aktivieren | Anwendungsliste |

| 15:00 | Zeit | Reguläre Ausdruck \d\d:\d\d |

| Jan | Person | E-Mails nach Jan durchsuchen |

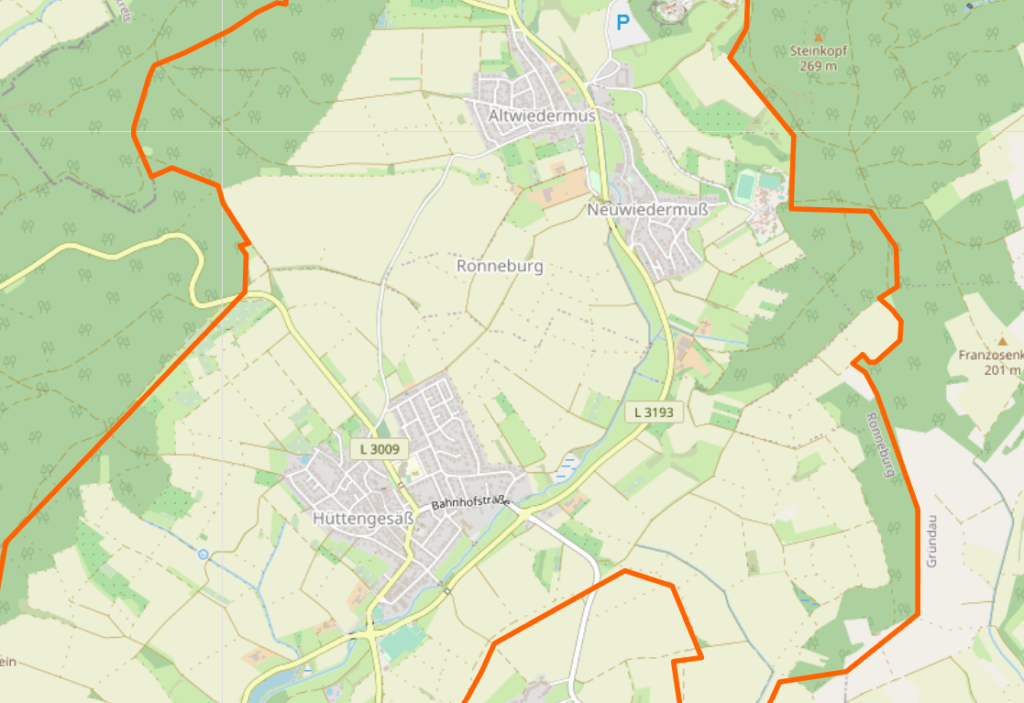

| Ronneburg | bekannten geografischer Ort | Open Street Map |

Wenn der Computer die wesentlichen Elemente aus dem Text extrahiert hat, fehlt dem Computer die Logik des Satzes.

„Konzeptionelle Abhängigkeitsstrukturen“ aus der NLP helfen dem Computer das Gesagte zu verstehen. Die Strukturen reduzieren die gesagten Worte auf 12 simple, abstrahierte Aktionen.

Wenn Informatiker mit Texten arbeiten !?

Bei diesem Vorgang gehen die sprachlichen Details und Feinheiten verloren, weil die Informatiker versuchen Aktionen zu vereinheitlichen.

Gehen, Rennen, Schleichen = MOVE in den konzeptionellen Abhängigkeitsstrukturen

In vielen Fällen reicht diese Form aus, um das Gesagte für den Computer abstrahiert verständlich zu machen, sodass dieser eine Antwort vorbereiten kann bzw. eine Aktion ausführt.

Von der Bedeutung zum Kontext (Pragmatik)

Wenn der Alexa-Server den Inhalt des Gesagten verstanden hat, kann er seine Programme parametergesteuert starten:

- Spiele „Jingle Bells“ –> 6 NLP Verarbeitungsschritte à

- Schreibe Milch auf meine Todoliste –> 6 NLP Verarbeitungsschritte à addToTodoliste(Item=Milch)

- Kaufe mir ein 6m Lan Kable von CSL–> 6 NLP Verarbeitungsschritte à buyViaAmazonPrime(Item=6MLANCSL)

- …

Lohnt sich Alexa für Amazon

Amazon hat viele Programmieraufwand in die Entwicklung von Alexa investiert.

Jede Verarbeitung der Sprache auf den Servern kostet dem Unternehmen Geld. Amazon nimmt diese Kosten in Kauf, weil …

- … der Kunden primär die Vorschläge aus dem Amazon Store bekommt.

- … die Kunden an seine Produkte (FireTable, FireTV usw.) noch besser bindet und ein eigenes Ökosystem mit Vendor-Lock-in erschafft.

- … Alexa nicht Marketplace Produkte präferiert.

- … integriert ist mit weiteren Bezahlservices wie Audible oder Prime Video.

- … ein permanenter, schneller und einfacher Zugang zu Amazon ist, sodass …

- … die Hemmschwelle etwas zu kaufen noch geringer ist.

- … Amazon die Kunden noch besser kennen lernt, Werbung personalisiert und Produkt Präsentationen anpasst.

Zusammenfassend, ist Alexa einer der besten Strategien, um ihre Kunden noch näher an den Konzern zu binden. Otto, Alibaba und andere Versandhändler sind in Deutschland noch nicht so weit.

Alexa ist Amazons neue Geldruckmaschine.